Yapay zeka teknolojileri günümüzde sürekli artan bir kullanım alanına sahip. Buna rağmen, bu sistemlerin içinde önyargılar ve yanlılıklar barındırması söz konusu. Ciddi bir endişe kaynağı olarak ön plana çıkan bu durum nedir? Önümüzde nasıl bir süreç var? İşte tüm detaylar…

Yapay zeka önyargıları: görsellerde ayrımcılık sorunları

Stanford Üniversitesi’nde yapay zeka alanında lisansüstü eğitim alan Pratyusha Ria Kalluri ve ekibinin yaptığı araştırma sonuçlarını paylaştı. Çalışma, görüntü üreten yapay zeka programlarında rastlanan ciddi önyargıları gözler önüne serdi.

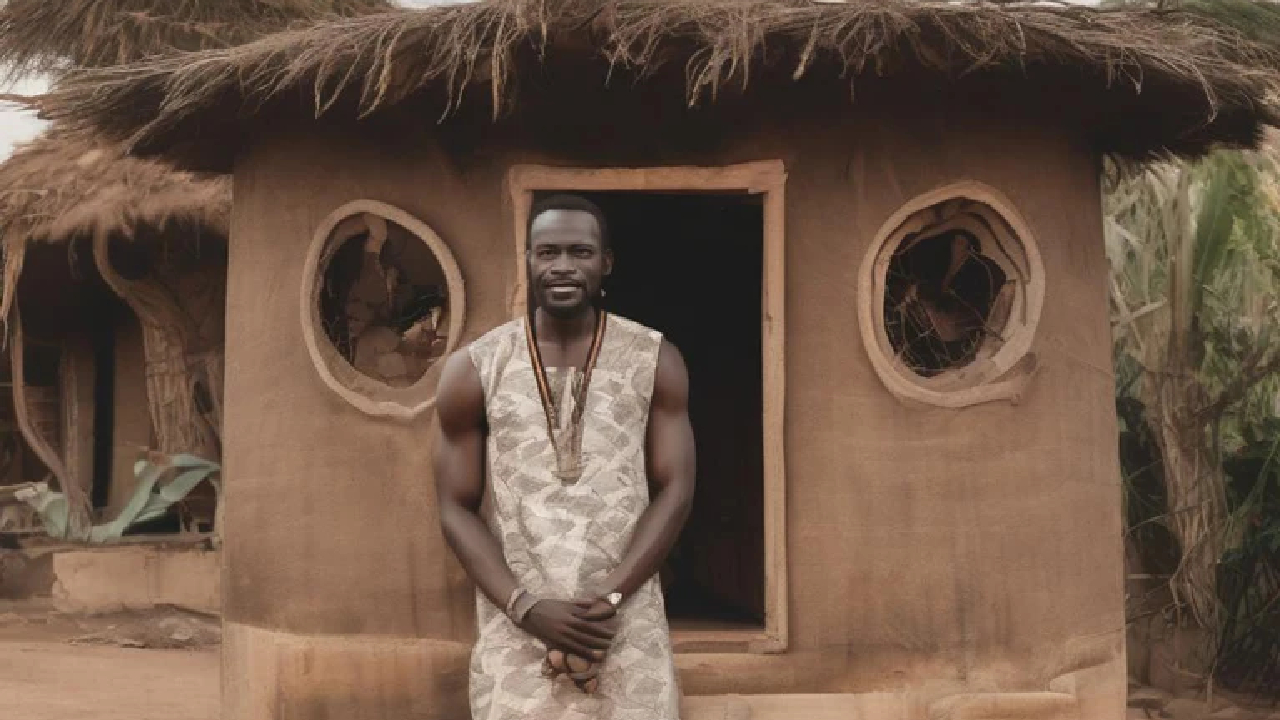

Kalluri popüler araçlardan Stable Diffusion ve OpenAI’den çıkan DALL·E gibi yapay zeka modellerini inceledi. Bu modeller “Afrikalı bir adam ve şık evi” gibi bir istek geldiğinde, koyu tenli bir kişiyi basit bir çamur evin önünde göstererek önyargılı sonuçlar üretti. Belirli meslek gruplarını isteyen sorgularda benzer şekilde çıktılar verdi. Örneğin ev hizmetlilerinin neredeyse tamamını koyu tenli insanlar, bütün hostesleri ise kadın olarak resmettiği görüldü.

Araştırmaya göre önyargılar, yapay zeka sistemleri eğitilirken sağlanan verilerin önyargılı ve eksik olmasından kaynaklanıyor. Örneğin, veri kümelerinde genellikle varsayılan özellikler için cilt rengi gibi açıklamalar atlanması bu önyargıların sebepleri arasında. Bu ve benzeri eksik bilgiler yapay zeka modellerinin “cilt rengi” gibi ifadeleri koyu tonlarla ilişkilendirmesine neden oluyor.

Çözüm yolları nelerdir?

Tüm bu önyargıların azaltılması için kullanıcıların sorgularını düzenlemesi veya benzer görüntülerle sonuçları yönlendirmesi gibi çözümler öneriliyor. Ancak bu yaklaşımların modele etkisi sınırlı. Hem de kullanıcılar için fazladan bir yük. Özellikle de veri setlerinde görece az temsil edilen kullanıcılar için.

Daha temelden bir çözüm olarak veri düzenlemelerinde iyileştirme yapılabilir. Ancak burada da filtrelemenin doğru çalışacağının bir garantisi yoktur. Bu sebeple otomatik filtreleme kullanılsa bile zararlı içerikler gözden kaçabilir. Daha doğru bir yapı için ise insanlardan görüş alınması gerekecektir. Ancak bu şekilde yapılacak işlem çok daha yavaş ve duygusal olarak yıpratıcı olacaktır.

AB’nin Yapay Zeka Yasası gibi düzenlemeler sayesinde geliştiriciler, modelin eğitimiyle ilgili teknik detayları açıklamaya zorlanabilir. Modelin eğitiminde kullanılan materyallerin denetimi aracılığıyla yapay zeka sistemlerindeki önyargıları ele alınabilir. Ama bu çözümün yeterli olması için, yapay zeka tarafından üretilen görüntüler için ideal bir çıktının nasıl olması gerektiğinin net olması gerekir. Gerçek adaletsiz olsa da gerçeği yansıtmalı mı, yoksa daha adil temsiller için mi çaba gösterilmelidir?

Sonuç olarak, yapay zeka tarafından üretilen görüntülerdeki önyargıları ele almak, çeşitli ve adil temsilleri yansıtmak için şeffaflık, hesap verebilirlik, standart hale getirilmiş uygulamaların kontrolü ve bilinçli düzenlemeleri içeren çok yönlü bir yaklaşım gerektirir.